Generative AI für Developer

Large Language Models (LLMs) wie ChatGPT oder ähnliche KI-Systeme eröffnen Unternehmen eine Vielzahl von Möglichkeiten. Ob als Kundenchatbot, Code-Assistent oder Wissensdatenbank, die Einsatzmöglichkeiten scheinen grenzenlos. Doch mit den Chancen gehen auch erhebliche Risiken einher. Bei der INFODAYS-Konferenz „Generative AI für Developer“ sprachen wir neben hochrangigen Expert:innen über die Risiken und Unsicherheiten beim Einsatz von LLMs in Anwendungen. Zudem zeigten wir Wege auf, wie diesen Herausforderungen systematisch begegnet werden kann.

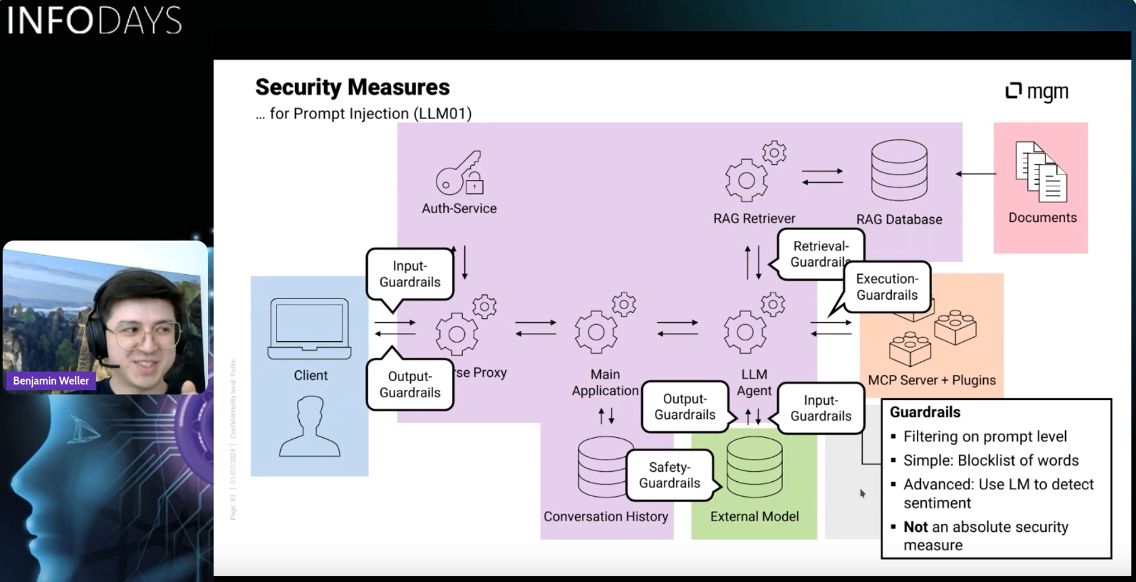

Im Zentrum des Vortrags stand eine LLM-Anwendung typischer Komplexität. Es werden sensibler Firmen- und Nutzerdaten mittels Retrievel-Augmented-Generation (RAG) eingebunden, mittels des Model-Context-Protocols (MCP) werden extern gehostete Plugins angesteuert und einer Orchestrierung durch das LLM. Anhand dessen haben wir mittels eines Threat-Modellings Assets (schutzbedürftige Ressourcen) der Anwendung hergeleitet und Bedrohungen identifiziert. Diese konnten wir dann in den etablierten Risikokatalog der OWASP Top 10 für LLM-Anwendungen einordnen. Zuletzt konnten wir daran Mitigationsstrategien herleiten, um unsere LLM-Anwendung abzusichern, gegen KI-Risiken und auch gegen herkömmliche Sicherheitsrisiken von Anwendungen.

Anschließend konnten wir uns gemeinsam in einer ausgedehnten Q&A-Session mit den Teilnehmenden austauschen und über die gezeigten Schutzstrategien diskutieren. Es zeigte sich, dass bei den Teilnehmenden das Bewusstsein für die Notwendigkeit von Sicherheit im LLM-Bereich grundsätzlich vorhanden war, jedoch bei den Details der Schutzmechanismen noch Unklarheiten herrschten. Somit gab es dort echtes Interesse und auch zahlreiche Nachfragen, die wir alle klären konnten. Besonders deutlich wurde, wie wichtig fundiertes Wissen über Sicherheit und ein tiefgehendes Verständnis der LLM-Komponenten für die Einschätzung von Risiken und Schutzmaßnahmen sind.

Wir möchten uns für die Einladung zu den Infodays und den Teilnehmenden für den tollen Austausch bedanken. Falls Sie an einer Schulung oder einer Analyse der Sicherheit Ihrer LLM-Anwendung interessiert sind, sprechen Sie uns gerne an!

Autor

Benjamin Weller ist Security-Berater und Penetration Tester. Als Trainer vermittelt er praxisnahes Security-Wissen und -Verständnis an Entwicklungsteams. Seit 2022 beschäftigt er sich mit generativen KI-Modellen und ihren Auswirkungen – im Raum der Datensicherheit, des Datenschutzes und auf die Gesellschaft.

Sie haben Fragen, oder wollen sich unverbindlich beraten lassen?

Nehmen Sie Kontakt per E-Mail auf, rufen Sie uns an oder nutzen Sie unser Kontaktformular.

SECURITY TESTING PLATTFORM

mgm ATLAS

mgm ATLAS ist die effiziente Integration von automatisierten Tests in Entwicklungsprozesse. Es ergänzt unseren Lean Application Security Ansatz optimal um eine schlanke und skalierbare Testplattform.