Im letzten Blogpost haben wir uns mit den grundsätzlichen Sicherheitsbedrohungen von Large Language Models (LLMs) befasst und gezeigt, wie wichtig es ist, bewährte Sicherheitspraktiken auf die neue Technologie zu übertragen. In unserem Fachartikel, welcher in der aktuellen Ausgabe vom JavaSPEKTRUM erscheint, gehen wir einen Schritt weiter: Wir analysieren anhand eines praxisnahen Szenarios typische Sicherheitsrisiken beim Einsatz von LLM-basierten Chatbots mit einem besonderen Fokus auf RAG-Systemen (Retrieval-Augmented Generation). Dabei verwenden wir den etablierten Risikokatalog der OWASP Top 10 für LLMs, kombiniert mit dem OWASP Threat Modeling Process.

Das Szenario: Ein interner Chatbot mit RAG-System

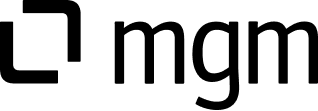

Stellen wir uns ein typisches Beispiel zur Integration von LLMs vor: Ein Unternehmen setzt einen internen Chatbot ein, der Mitarbeitenden als Wissensdatenbank für Wiki-Inhalte und der Codedokumentation dient. Die Architektur setzt sich aus mehreren Schlüsselkomponenten zusammen: einem LLM-Agenten, einem extern angebundenen Modell, sowie einem RAG-System (blau hinterlegt), welches die Wiki-Inhalte und Codedokumentation für Anfragen bereitstellt und in einer Vektor-Datenbank speichert:

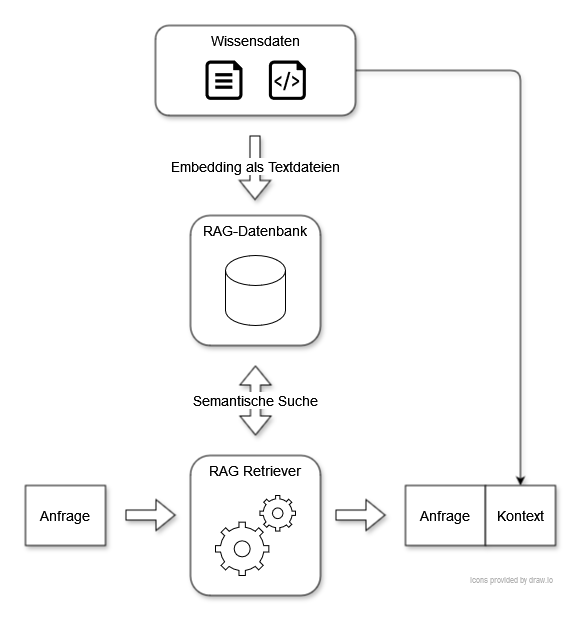

Möchte ein Mitarbeiter nun Informationen aus dem Chatbot abfragen, wird die Anfrage zunächst durch den LLM-Agenten entgegengenommen. Danach wird der RAG-Retriever verwendet, welcher die für die Anfrage relevantesten Dokumente aus der RAG-Datenbank heraussucht. Dies wird semantische Suche genannt. Diese werden als Kontext zur Anfrage des Mitarbeiters hinzugefügt und an das LLM gegeben. Dieses kann dann durch den Kontext eine relevante Antwort generieren.

Die strukturierte Bedrohungsanalyse zeigt uns den Weg

Gerade Chatbots mit RAG-Anbindung greifen auf sensible Unternehmensdaten zu, was sie für Angreifer besonders interessant macht. In unserem Fachartikel analysieren wir nach dem OWASP Threat Modeling Process, welche Assets besonders geschützt werden müssen, etwa interne Dokumente, Code, die Vektor-Datenbank, die Verfügbarkeit der Anwendung und die Kosten der externen Modellnutzung. Auf dieser Grundlage betrachten wir fünf zentrale Risiken aus den OWASP Top 10 für LLMs und illustrieren diese anhand konkreter Beispiele aus der Praxis:

- Prompt Injection: Prompt Injection stellt eine der größten Bedrohungen für LLM-Anwendungen dar, und ist oft das Einfallstor für die Ausnutzung weiterer Schwachstellen. Angreifer manipulieren dabei gezielt Prompts, um das Modell zu unerwünschten Ausgaben zu bewegen, beispielsweise die Offenlegung sensibler Informationen. Besonders gefährlich ist, dass laut aktuellem Stand der Wissenschaft keine absoluten Schutzmechanismen gegen Prompt Injection gibt, da Nutzereingaben und Systemanweisungen technisch nicht strikt getrennt werden können.

- Offenlegung sensibler Informationen: Dies beschreibt das grundlegende Risiko, dass ein Angreifer Zugriff auf sensible Daten unserer LLM-Anwendung erhalten kann. Zum Beispiel kann er versuchen, mittels Prompt Injection vertrauliche Daten aus den internen Wissensdaten oder der Codedokumentation zu extrahieren. Allerdings besteht beispielsweise auch das Risiko, dass sensible Chatdaten in Protokolldateien gespeichert und unzureichend geschützt werden.

- Preisgabe des Systemprompts: Systemprompts dienen dazu, die Anfragen des Nutzers zu kontextualisieren und die Antworten des LLM zu steuern. Beispielsweise können Informationen über die Struktur der Wissensdatenbank enthalten sein, um die Antwort relevanter zu gestalten. Der Systemprompt kann auch genutzt werden, um bestimmte Gesprächsthemen wie etwa Hassrede oder Beleidigungen zu unterbinden. Schafft ein Angreifer, den Systemprompt beispielsweise mittels Prompt Injection offenzulegen, kann er gezieltere Angriffe starten und Schutzmechanismen gezielt umgehen.

- Unsichere Ausgabebehandlung: Dieses Risiko bezeichnet die unzureichende Validierung von LLM-Ausgaben. Werden diese ungeprüft in nachgelagerten Systemen verarbeitet oder im Browser angezeigt, kann ein Angreifer beispielsweise Cross-Site-Scripting (XSS) oder die Exfiltration von Daten über eingebetteten Code im Markdown-Format auslösen.

- Schwachstellen im Embedding-Prozess: Angreifer mit Zugriff auf Quelltexte (z. B. das interne Wiki) können den Embedding-Prozess nutzen, um schädliche Inhalte einzuschleusen. Diese werden in der Vektor-Datenbank gespeichert und können dazu führen, dass bei Anfragen falsche oder manipulierte Informationen ausgegeben werden.

Fazit

LLM-basierte Chatbots bieten Unternehmen einen großen Mehrwert, bringen aber auch neuartige Sicherheitsrisiken mit sich. Der Einsatz von RAG-Systemen erhöht die Komplexität zusätzlich. Mit etablierten Methoden wie den OWASP Top 10 für LLMs und dem OWASP Threat Modeling Prozess lassen sich Risiken systematisch identifizieren und adressieren. Entscheidend ist, dass die Bausteine der genutzten LLM-Anwendungen verstanden, die Risiken systematisch adressiert, und die Schutzmaßnahmen konsequent umgesetzt werden. Im zweiten Teil unseres Fachartikels analysieren wir weitere Risiken, und stellen praxisnahe Strategien zur Absicherung der Beispielanwendung vor.

Der Artikel erschien in der Mai Ausgabe 2025 im Java Spektrum von SIGS.DE